Na czym polega backpropagation w sieciach neuronowych?

Backpropagation to proces uczenia sieci neuronowej polegający na cofnięciu się przez warstwy modelu i obliczaniu, jak bardzo każda waga wpłynęła na końcowy błąd. Dzięki temu algorytm stopniowo poprawia swoje działanie, precyzyjnie dostosowując parametry, by uzyskać coraz lepsze wyniki. To właśnie ten mechanizm sprawia, że sieć uczy się rozpoznawać wzorce i podejmować trafniejsze decyzje.

Co to jest backpropagation i dlaczego jest kluczowe w sieciach neuronowych?

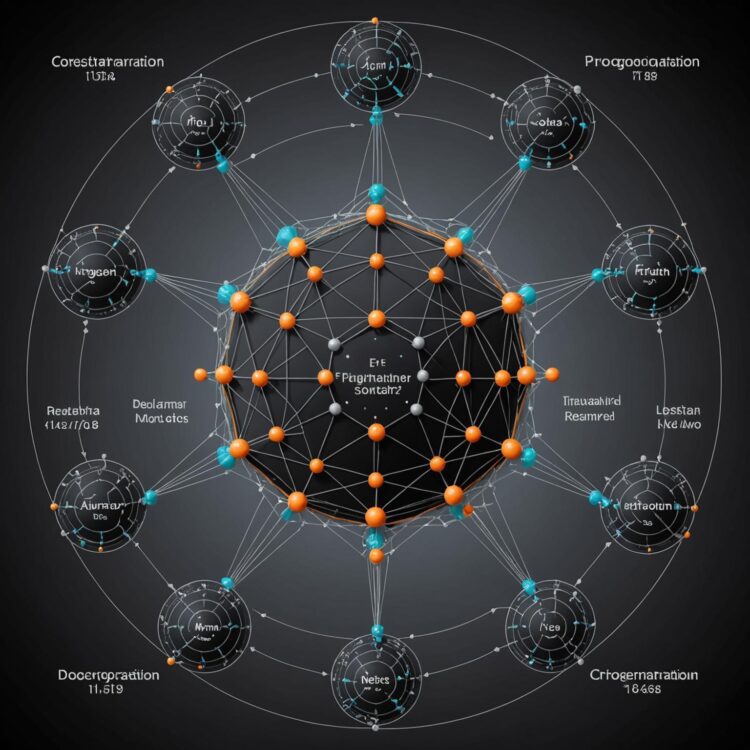

Backpropagation to fundamentalny algorytm umożliwiający uczenie się sieci neuronowych poprzez efektywne minimalizowanie błędu predykcji. Jego istota polega na propagacji błędu końcowego z warstwy wyjściowej z powrotem do wcześniejszych warstw, co pozwala na systematyczne korygowanie wag w całej architekturze sieci. Dzięki zastosowaniu reguły łańcuchowej rachunku różniczkowego, backpropagation pozwala na obliczenie gradientów funkcji kosztu względem wszystkich wag w sieci. To właśnie te gradienty są niezbędne do dalszej aktualizacji parametrów metodami optymalizacji, takimi jak gradient prosty czy Adam.

Kluczowa rola backpropagation wynika z jego wydajności obliczeniowej i możliwości przeprowadzania procesu uczenia w złożonych, wielowarstwowych sieciach. W odróżnieniu od naiwnych sposobów uczenia, backpropagation pozwala na jednoczesne uwzględnianie wpływu błędów w całej sieci, co czyni go skalowalnym rozwiązaniem dla głębokiego uczenia (deep learning). Algorytm ten jest standardem zarówno w prostych sieciach perceptronowych, jak i w zaawansowanych sieciach konwolucyjnych, rekurencyjnych oraz transformers. Dowodem jego skuteczności jest fakt, że praktycznie wszystkie nowoczesne osiągnięcia w dziedzinie sztucznej inteligencji – w tym rozpoznawanie obrazów, analiza języka naturalnego i automatyczne tłumaczenia – wykorzystują warianty backpropagation do treningu swoich modeli.

Bez backpropagation trenowanie wielowarstwowego perceptronu byłoby niewykonalne z praktycznego punktu widzenia. Obliczeniowa prostota tego algorytmu polega na wykorzystaniu tych samych wartości pochodnych zarówno podczas przechodzenia sygnału w przód, jak i przy propagacji błędu wstecz, co pozwala na radykalne zmniejszenie zapotrzebowania na pamięć i czas obliczeniowy. Ponadto, wykorzystanie dynamicznego programowania (przechowywanie pośrednich wyników) umożliwia trenowanie głębokich sieci nawet na dużych zbiorach danych.

W praktyce, skuteczność backpropagation została potwierdzona eksperymentalnie i teoretycznie w setkach badań naukowych. Na przykład, benchmarki ImageNet i CIFAR-10 wykazują, że sieci trenowane tym algorytmem osiągają wyraźnie lepsze wyniki klasyfikacji w porównaniu do innych metod. Oznacza to, że bez backpropagation rozwój współczesnych zastosowań sieci neuronowych na obecnym poziomie byłby niemożliwy.

Jak działa algorytm backpropagation krok po kroku?

Algorytm backpropagation działa w kilku następujących po sobie krokach, umożliwiając efektywne uczenie się sieci neuronowej. W pierwszym etapie wykonywane jest przejście do przodu (forward pass): wejściowe dane są przekazywane przez kolejne warstwy sieci, a na końcu obliczany jest wynik oraz funkcja kosztu, która mierzy błąd predykcji względem wartości oczekiwanych. Następnie rozpoczyna się kluczowa część procesu – propagacja wsteczna i wyznaczanie gradientów funkcji kosztu względem wag i biasów każdej warstwy, wykorzystując regułę łańcuchową rachunku różniczkowego (chain rule).

Obliczone gradienty są następnie przesyłane od warstwy wyjściowej do wejściowej, umożliwiając sukcesywne wyznaczenie wpływu poszczególnych wag na końcowy błąd. To pozwala na zaktualizowanie parametrów według algorytmu optymalizacji, zazwyczaj metodą spadku gradientu. W praktyce procedura ta jest powtarzana iteracyjnie dla każdej próbki lub partii próbek (mini-batch), aż sieć osiągnie satysfakcjonujące parametry.

Proces można podsumować w następujących krokach:

- Przekazanie danych przez sieć (forward pass) i obliczenie straty końcowej.

- Obliczenie gradientu funkcji kosztu względem aktywacji wyjściowej sieci.

- Wsteczna propagacja gradientów przez kolejne warstwy przy użyciu reguły łańcuchowej.

- Uzyskanie gradientów względem wag i biasów każdej warstwy.

- Aktualizacja wag i biasów zgodnie z wybranym algorytmem optymalizacyjnym.

Wydajne obliczanie pochodnych odgrywa tu zasadniczą rolę, często przy wykorzystaniu automatycznego różniczkowania i pamiętania wyników pośrednich (caching) podczas przejścia do przodu, co znacznie redukuje koszty obliczeniowe. Algorytm pozwala na trenowanie bardzo głębokich sieci neuronowych – bez niego efektywne uczenie warstw wielopoziomowych byłoby praktycznie niemożliwe.

Do czego służy funkcja kosztu w backpropagation?

Funkcja kosztu w procesie backpropagation określa miarę błędu popełnianego przez sieć neuronową podczas przewidywania wyników dla danego zestawu danych. Pozwala to ocenić różnicę między wyjściami sieci a oczekiwanymi wartościami, przyjmując postać np. błędu średniokwadratowego (MSE) dla regresji lub entropii krzyżowej w zadaniach klasyfikacyjnych. Dzięki ujednoliconej postaci funkcji kosztu możliwe jest matematyczne opisanie problemu optymalizacji wag w sieci.

Główną rolą funkcji kosztu w backpropagation jest wskazanie, jak mocno i w którym kierunku należy zaktualizować każdą wagę sieci w celu minimalizacji błędu. Wartość tej funkcji jest wyliczana po zakończeniu procesu propagacji sygnału do przodu, a to właśnie jej pochodne względem poszczególnych wag są kluczowym elementem podczas propagacji wstecznej. Dzięki funkcji kosztu można wyznaczyć gradient, co pozwala zastosować optymalizatory, takie jak stochastic gradient descent (SGD), Adam czy RMSProp.

Przy wyborze funkcji kosztu należy uwzględnić rodzaj rozwiązywanego problemu, ponieważ różne funkcje mają odmienne właściwości i wpływają na zbieżność procesu uczenia. Poniżej przedstawiono najczęściej stosowane funkcje kosztu wraz z obszarem ich zastosowania w sieciach neuronowych:

| Funkcja kosztu | Wzór matematyczny | Zastosowanie |

|---|---|---|

| Błąd średniokwadratowy (MSE) | ( frac{1}{n} sum_{i=1}^n (y_i – hat{y}_i)^2 ) | Regresja |

| Entropia krzyżowa | ( -sum_{i=1}^n y_i log(hat{y}_i) ) | Klasyfikacja binarna/wieloklasowa |

| Hinge loss | ( max(0, 1 – y_i cdot hat{y}_i) ) | Klasyfikacja SVM |

| Kullback–Leibler divergence | ( sum_{i=1}^n y_i logleft(frac{y_i}{hat{y}_i}right) ) | Modele probabilistyczne |

Odpowiednie dobranie funkcji kosztu decyduje o efektywności całego procesu uczenia sieci. Niewłaściwy wybór może prowadzić do złej zbieżności lub niestabilności modelu podczas uczenia, dlatego jej rola w backpropagation jest absolutnie fundamentalna. Funkcja ta gwarantuje, że aktualizacja wag opiera się na precyzyjnie wyliczonej informacji zwrotnej, bezpośrednio przekładającej się na poprawę działania modelu.

W jaki sposób obliczane są pochodne podczas propagacji wstecznej?

Pochodne podczas propagacji wstecznej (backpropagation) w sieciach neuronowych są wyliczane poprzez systematyczne zastosowanie reguły łańcuchowej różniczkowania do funkcji kosztu względem wag i bias’ów w każdej warstwie sieci. Kluczowe jest analizowanie, jak zmiana pojedynczego parametru wpływa na końcowy błąd sieci, poczynając od końcowego wyniku (output layer) i cofając się aż do wejścia sieci (input layer).

Proces obliczeń wymaga zapisania pośrednich wartości aktywacji oraz lokalnych pochodnych funkcji aktywacji i wag na każdym etapie propagacji sygnału w przód (forward pass). Backpropagation korzysta z tych zachowanych wartości, by szybko i efektywnie wyliczyć gradienty bez konieczności wielokrotnego przeliczania tej samej części sieci. W praktyce, dla funkcji aktywacji takich jak sigmoid czy ReLU, stosuje się analityczne wzory ich pochodnych, aby uzyskać wartości dokładne dla każdego neuronu.

Aby lepiej zobrazować sposób wyliczania pochodnych w procesie propagacji wstecznej dla sieci neuronowych, poniżej przedstawiono porównanie najczęściej stosowanych funkcji aktywacji i wyrażenia dla ich pochodnych wykorzystywane w algorytmie backpropagation:

| Nazwa funkcji | Wyrażenie funkcji | Pochodna | Zastosowanie w sieciach |

|---|---|---|---|

| Sigmoid | σ(x) = 1 / (1 + e-x) | σ(x) • (1 – σ(x)) | Wyjścia binarne, warstwy końcowe |

| ReLU | ReLU(x) = max(0, x) | 1 (x > 0), 0 (x ≤ 0) | Warstwy ukryte, głębokie sieci |

| Tanh | tanh(x) = (ex – e-x) / (ex + e-x) | 1 – tanh2(x) | Warstwy ukryte, dane znormalizowane |

Z powyższej tabeli wynika, że różne funkcje aktywacji wymagają dostosowania obliczeń pochodnych w ramach algorytmu backpropagation, co może mieć istotny wpływ na zbieżność uczenia. Poprawne wyznaczanie pochodnych dla wybranej funkcji aktywacji jest kluczowe do uzyskiwania gradientów o właściwych wartościach, co bezpośrednio przekłada się na skuteczność aktualizacji wag podczas procesu optymalizacji.

Jakie są najczęstsze problemy i ograniczenia związane z backpropagation?

Backpropagation napotyka na wiele problemów, które utrudniają efektywne uczenie głębokich sieci neuronowych już na podstawowym poziomie. Najpowszechniejszym ograniczeniem jest zanikający lub eksplodujący gradient, gdy wartości pochodnych w warstwach odległych od wyjścia stają się niezwykle małe lub bardzo duże. Powoduje to, że wagi w początkowych warstwach praktycznie nie są aktualizowane lub aktualizowane są w niestabilny sposób, co prowadzi do bardzo wolnej konwergencji lub całkowitej niestabilności procesu uczenia. Problem ten jest szczególnie widoczny przy użyciu funkcji aktywacji takich jak sigmoid czy tanh, co potwierdzają badania Bengio i kol. (1994).

W przypadku dużych zbiorów danych i rozbudowanych sieci kluczową przeszkodą jest ogromne zapotrzebowanie na moc obliczeniową i pamięć operacyjną. Proces propagacji wstecznej wymaga przechowywania wszystkich pośrednich wyników każdej warstwy podczas przechodzenia sygnału w przód oraz podczas liczenia pochodnych wstecz. To prowadzi do znacznego wzrostu wymagań sprzętowych, co może być czynnikiem ograniczającym skalowanie modeli.

Backpropagation wiąże się także z kłopotami optymalizacyjnymi, takimi jak utknięcie gradientów w lokalnych minimach lub obszarach płaskich funkcji kosztu (tzw. saddle points). Skutkuje to wolniejszym postępem uczenia lub nawet jego zatrzymaniem. Fakty te są potwierdzone analizami krajobrazu funkcji kosztu (np. Dauphin et al., 2014), które wykazują, że w głębokich sieciach minima globalne są rzadkie, a większość punktów krytycznych ma płaską charakterystykę.

Warto również wspomnieć o podatności backpropagation na overfitting, czyli nadmierne dopasowanie modelu do danych treningowych. Wynika to z faktu, że algorytm szuka lokalnych minimum bez uwzględnienia generalizacji. Dodatkowo algorytm zakłada, że funkcja kosztu jest gładka i różniczkowalna względem wag, przez co ograniczony zostaje wybór potencjalnych architektur sieci lub typów funkcji aktywacji.

Kiedy stosować backpropagation i czy zawsze jest najlepszym wyborem?

Backpropagation stosuje się przede wszystkim podczas trenowania głębokich sieci neuronowych, gdy wymagana jest efektywna optymalizacja dużych zbiorów parametrów. Technika ta jest najlepszym wyborem w klasycznych architekturach warstwowych, takich jak perceptron wielowarstwowy, sieci konwolucyjne czy podstawowe sieci rekurencyjne. Backpropagation jest skuteczny tam, gdzie funkcja kosztu oraz aktywacji są różniczkowalne – to kluczowy warunek jego zastosowania.

Mimo powszechnego użycia, backpropagation nie zawsze sprawdza się najlepiej. Jego efektywność gwałtownie spada w przypadku bardzo głębokich sieci przez problem zanikającego gradientu. Problematyczny jest również dla sieci zawierających nieliniowe, nieróżniczkowalne funkcje aktywacji lub przy pracy z architekturami, w których trudno uzyskać oznaczone dane – na przykład w modelach uczenia ze wzmocnieniem i sieciach generatywnych. W tych sytuacjach stosuje się inne rozwiązania, takie jak propagacja wsteczna przez czas (BPTT), algorytmy genetyczne, propagację różniczkową przez próbki (REINFORCE), a także metody ewolucyjne czy uogólnione metody estymacji.

Aby zobrazować zastosowania oraz ograniczenia backpropagation, poniżej znajduje się tabela porównawcza różnych metod optymalizacji parametrów sieci neuronowych:

| Metoda optymalizacji | Główne zastosowanie | Obsługa funkcji nieróżniczkowalnych | Radzenie sobie z zanikiem gradientu | Trening bez danych oznaczonych |

|---|---|---|---|---|

| Backpropagation | Klasyczne sieci warstwowe | Nie | Słabo | Nie |

| BPTT (Backpropagation Through Time) | Zaawansowane sieci rekurencyjne | Nie | W pewnym stopniu | Nie |

| Algorytmy genetyczne | Różniczkowalność nie jest wymagana | Tak | Tak | Tak |

| REINFORCE, policy gradients | Uczenie ze wzmocnieniem | Tak | Aby obejść problem zanikającego gradientu | Tak |

Jak widać na powyższym zestawieniu, skuteczność backpropagation w dużej mierze zależy od architektury sieci, rodzaju funkcji oraz dostępu do danych, natomiast alternatywne metody stają się niezbędne przy mniej standardowych wymaganiach lub ograniczeniach strukturalnych.