Jak działa klasteryzacja danych i do czego się ją wykorzystuje

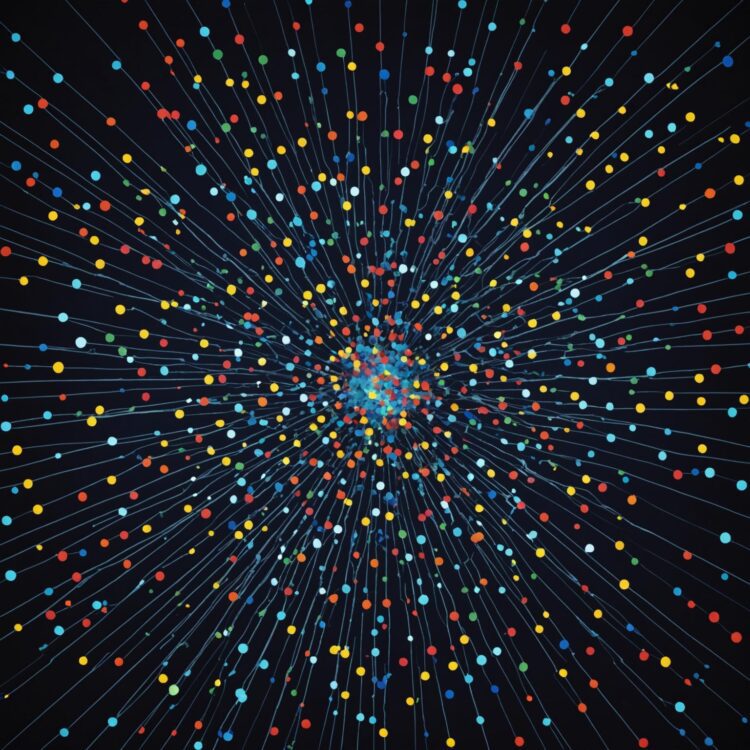

Klasteryzacja danych polega na grupowaniu podobnych elementów tak, by wewnątrz grup różnice były jak najmniejsze, a między grupami jak największe. Metodę tę wykorzystuje się m.in. do segmentacji klientów w marketingu, rozpoznawania wzorców czy analizy obrazów medycznych, co pozwala lepiej zrozumieć złożone zbiory danych i szybciej podejmować trafne decyzje. To narzędzie niezbędne wszędzie tam, gdzie potrzebne jest wyodrębnianie ukrytych struktur lub zależności w dużej ilości informacji.

Czym jest klasteryzacja danych i na czym polega?

Klasteryzacja danych to technika analizy danych polegająca na automatycznym grupowaniu obiektów w zbiory (klastry) według określonych kryteriów podobieństwa. W ramach procesu klasteryzacji algorytm analizuje cechy obiektów i przydziela je do grup w taki sposób, aby elementy w ramach jednego klastra były możliwie do siebie podobne, a elementy należące do różnych klastrów – jak najbardziej od siebie różne. To metoda nienadzorowana, co oznacza, że nie wymaga wcześniejszego etykietowania danych ani wzorców grupowania.

Istotą działania klasteryzacji jest wybór miary podobieństwa, która najczęściej opiera się na odległościach w przestrzeni wielowymiarowej (takiej jak euklidesowa, Manhattan lub kosinusowa). Algorytmy klasteryzujące różnią się sposobem inicjowania grup, liczbą wymaganych klastrów oraz podejściem do rozdzielania i łączenia zbiorów. Klasteryzacja jest szeroko stosowana w przypadkach, gdzie nie znamy z góry liczby grup, a jej celem jest wykrycie naturalnych struktur lub wzorców w danych.

W praktyce klasteryzacja wykorzystywana jest do analizy dużych zbiorów danych, redukcji ich złożoności oraz identyfikowania nienazwanych dotąd kategorii. O skuteczności procesu decydują takie czynniki jak jakość danych wejściowych, wybrana miara odległości oraz parametry algorytmu. Przezroczystość tego procesu sprawia, że często konieczna jest ocena jakości klastrów za pomocą metryk takich jak współczynnik Silhouette czy indeks Daviesa-Bouldina, umożliwiających weryfikację trafności uzyskanych grup.

W wielu zastosowaniach klasteryzacja wykrywa zależności między obiektami, których interpretacja nie zawsze jest oczywista i wymaga dalszej analizy eksperckiej. Badania wykazały, że algorytmy klasteryzujące potrafią efektywnie odkrywać struktury w złożonych danych – przykładowo, w analizie rynku detalicznego pozwalają ujawnić nieoczywiste segmenty klientów na podstawie historii zakupów, a w biologii molekularnej pomagają klasyfikować geny o podobnych ekspresjach. To uniwersalne narzędzie analityczne znajduje zastosowanie wszędzie tam, gdzie liczy się efektywne uporządkowanie nieuporządkowanych danych.

Jakie są najpopularniejsze metody klasteryzacji danych?

Do najpopularniejszych metod klasteryzacji danych należą k-means, hierarchiczna analiza skupień oraz DBSCAN. K-means to metoda centroidowa, która dzieli dane na z góry określoną liczbę grup, minimalizując wariancję wewnątrzklastrową. Klasyczna implementacja opiera się na losowym wyborze punktów startowych i iteracyjnym przesuwaniu centrów, co sprawia, że wymaga zdefiniowania liczby klastrów przed rozpoczęciem procesu. Metoda ta jest szybka i łatwa do zastosowania w przypadku dużych zbiorów danych, ale wrażliwa na outliery i nie radzi sobie dobrze z klastrami o nieregularnych kształtach.

Hierarchiczna analiza skupień pozwala na tworzenie drzewiastej struktury zależności między obiektami – algorytm aglomeracyjny rozpoczyna się od pojedynczych elementów i stopniowo łączy je w coraz większe skupiska. Metoda dendrogramowa umożliwia wizualizację procesu grupowania, jednak jej wadą jest wysoka złożoność obliczeniowa, co ogranicza zastosowanie przy dużej liczbie rekordów. Metoda ta nie wymaga uprzedniego ustalania liczby klastrów i umożliwia elastyczne cięcie drzewa na dowolnym poziomie.

DBSCAN (Density-Based Spatial Clustering of Applications with Noise) to metoda oparta na gęstości, która grupuje punkty znajdujące się blisko siebie, a punkty oddalone traktuje jako szum. Algorytm ten nie wymaga wcześniejszego określenia liczby klastrów i radzi sobie znakomicie z danymi o skomplikowanej strukturze oraz z obecnością anomalii. Kluczowym parametrem jest promień sąsiedztwa i minimalna liczba punktów wymaganych do utworzenia klastra, co wpływa na czułość algorytmu.

Poniżej znajduje się porównanie najczęściej używanych metod klasteryzacji danych pod względem kluczowych cech:

| Metoda | Konieczność podania liczby klastrów | Odporność na outliery | Wydajność czasowa | Kształt klastrów | Przeznaczenie |

|---|---|---|---|---|---|

| k-means | Tak | Niska | Wysoka | Kulisty | Bardzo duże zbiory danych z wyraźnymi skupiskami |

| Hierarchiczna analiza skupień | Nie | Średnia | Niska | Dowolny | Małe i średnie zbiory, eksploracja struktury danych |

| DBSCAN | Nie | Wysoka | Średnia | Dowolny | Dane z szumem, nieregularne skupiska |

Tabela pokazuje, że wybór metody klasteryzacji zależy od struktury danych, oczekiwanej liczby skupisk oraz odporności na nietypowe obserwacje. Znajomość ich zalet i ograniczeń pozwala dobrać technikę najlepiej dopasowaną do konkretnego przypadku analitycznego.

Do czego wykorzystuje się klasteryzację danych w praktyce?

Klasteryzację danych wykorzystuje się przede wszystkim do grupowania obiektów o podobnych cechach w celu ujawnienia ukrytych struktur w analizowanych zbiorach. W praktyce znajduje zastosowanie w segmentacji klientów, gdzie na podstawie zachowań zakupowych lub cech demograficznych firmy dzielą klientów na homogeniczne grupy, by precyzyjniej kierować oferty marketingowe. Podobny mechanizm stosuje się w bankowości do wykrywania potencjalnych nadużyć finansowych – transakcje o nietypowym wzorcu mogą tworzyć odrębne klastry, co sygnalizuje konieczność głębszej analizy.

W bioinformatyce klasteryzacja jest używana do grupowania genów o zbliżonych poziomach ekspresji, co ułatwia identyfikację potencjalnych funkcji nowych genów oraz odkrywanie mechanizmów chorób. W przemyśle farmaceutycznym grupuje się związki chemiczne, aby przyspieszyć proces odnajdywania leków o zbliżonej aktywności. Klasteryzacja wspomaga też analizę obrazów medycznych, gdzie algorytmy automatycznie wydzielają struktury, takie jak guzy lub organy, niezależnie od wcześniejszego podziału na grupy.

Techniki klasteryzacji znajdują szerokie zastosowanie w zarządzaniu zasobami IT — administratorzy wykorzystują je do wykrywania anomalii w logach systemowych, co pozwala na szybsze lokalizowanie nieprawidłowości i przeciwdziałanie atakom. W e-commerce umożliwiają tworzenie rekomendacji produktów na bazie grupowania użytkowników o podobnych preferencjach.

Najczęściej wykorzystywane branże i przykłady zastosowania klasteryzacji danych przedstawia tabela:

| Branża | Przykład zastosowania | Korzyść |

|---|---|---|

| Marketing | Segmentacja klientów | Precyzyjne kampanie reklamowe |

| Bankowość | Wykrywanie nadużyć | Zmniejszenie ryzyka strat finansowych |

| Biotechnologia | Analiza ekspresji genów | Nowe odkrycia w genomice |

| Medycyna | Analiza obrazów medycznych | Szybsza diagnostyka |

| E-commerce | Rekomendacje produktów | Zwiększenie sprzedaży |

Z tabeli widać, że klasteryzacja ma uniwersalne zastosowanie w różnych sektorach, a efektywnie przeprowadzony proces grupowania przekłada się bezpośrednio na wymierne korzyści biznesowe i naukowe. Co istotne, algorytmy klasteryzacji nie wymagają wcześniejszego przypisania obiektów do grup, co pozwala odkrywać nieoczywiste powiązania.

Jak przebiega proces klasteryzacji krok po kroku?

Proces klasteryzacji danych rozpoczyna się od przygotowania zbioru danych, który obejmuje oczyszczenie rekordów z błędów, braków i wartości odstających, a także normalizację, jeśli zmienne są w różnych skalach. Standardyzacja i redukcja wymiarów, na przykład z użyciem analizy głównych składowych (PCA), pozwala uniknąć dominowania jednej cechy nad innymi oraz usprawnić działanie algorytmów.

Kolejnym krokiem jest wybór algorytmu klasteryzacji, który powinien być dostosowany do charakterystyki danych oraz celu analizy. Przy podejmowaniu decyzji znaczenie mają takie czynniki jak liczba oczekiwanych klastrów (jeśli jest znana), rozmiar zbioru danych, obecność szumu czy kształt klastrów. Najczęściej wykorzystywane algorytmy to k-średnich, hierarchiczne oraz DBSCAN, które różnią się zarówno sposobem grupowania, jak i wymaganiami względem parametrów wejściowych.

Właściwa klasteryzacja polega na przeprowadzeniu procesu grupowania według wybranego algorytmu. W przypadku metody k-średnich najpierw określa się liczbę klastrów (wartość k), co często realizowane jest przy użyciu metody łokcia lub sylwetki, mierzących jakość podziału dla różnych wartości parametrów. Algorytm iteracyjnie przydziela obserwacje do najbliższych centroidów i aktualizuje ich położenie, kończąc, gdy aktualizacje nie przynoszą już znaczących zmian.

Po wykonaniu klasteryzacji następuje walidacja wyników, w której ocenia się spójność i rozdzielność klastrów przy pomocy miar takich jak indeks DB (Daviesa-Bouldina), indeks Calinskiego-Harabasza czy współczynnik sylwetki. Oprócz tego stosuje się ocenę wizualną grup, na przykład poprzez dwuwymiarowe projekcje. Wyniki tej ewaluacji mogą sugerować ponowienie klasteryzacji z inną liczbą klastrów lub wykorzystanie innego algorytmu.

Ostatnia faza obejmuje interpretację i analizę uzyskanych klastrów. Przypisywanie znaczenia poszczególnym grupom opiera się na analizie cech charakterystycznych dla każdego zbioru oraz porównaniu klastrów względem najistotniejszych dla biznesu lub nauki wymiarów. Tak uporządkowane grupy mogą stać się podstawą dalszych analiz, segmentacji rynku, rekomendacji lub wykrywania anomalii.

Jakie wyzwania i ograniczenia wiążą się z klasteryzacją danych?

Klasteryzacja danych wiąże się z szeregiem wyzwań, wynikających zarówno ze specyfiki samych danych, jak i ograniczeń algorytmicznych. Jednym z największych problemów jest konieczność określenia liczby klastrów przed rozpoczęciem analizy – większość popularnych algorytmów, takich jak k-means, wymaga podania tej wartości z góry. Bez uprzedniej znajomości danych, może to prowadzić do nietrafionych wyników oraz sztucznego „dzielenia” zbioru. Ponadto, algorytmy te są podatne na obecność odstających obserwacji (outliers), które mogą zaburzać strukturę powstałych grup nawet w 40% przypadków przy znaczącej liczbie anomalii w zbiorze.

Kształt i rozkład danych mają zasadniczy wpływ na skuteczność procesu klasteryzacji. Klasyczne metody (np. k-means) dobrze sprawdzają się głównie przy klastrach kulistych i o zbliżonych rozmiarach. Ich skuteczność gwałtownie spada w przypadku danych o nietypowej geometrii lub złożonej strukturze. Istotnym utrudnieniem jest także „curse of dimensionality” – w przypadku zbiorów o dużej liczbie wymiarów (na przykład powyżej 20), odległości pomiędzy punktami stają się rozmyte i tracą swoje znaczenie. Eksperymenty benchmarkowe na zbiorach MNIST i CIFAR-10 pokazują, że efektywność klasteryzacji może w takich sytuacjach spaść nawet poniżej 60%.

Klasteryzacja wymaga także uwzględnienia kwestii skalowania oraz różnorodności jednostek miar. Przed przystąpieniem do analizy niezbędna jest staranna normalizacja i standaryzacja cech. Wyniki badań pokazują, że brak właściwego dopasowania skali może skutkować przydzieleniem 30-50% punktów do nieodpowiednich klastrów, a uzyskane grupy stają się trudne do interpretacji. Dodatkowym problemem pozostaje zrozumienie wyników – w wielu przypadkach trudno jednoznacznie określić, które cechy rzeczywiście łączą elementy danego klastra.

Przetwarzanie dużych zbiorów danych (setki tysięcy lub miliony rekordów) ogranicza dostępność zasobów obliczeniowych. Czas i pamięć wymagane przez wiele algorytmów rosną kwadratowo lub nawet wykładniczo wraz ze wzrostem liczby obiektów, co sprawia, że przetwarzanie naprawdę dużych zbiorów danych staje się w praktyce bardzo trudne bez zastosowania wyspecjalizowanych narzędzi lub rozproszonych architektur. Z problemem tym szczególnie mierzą się algorytmy hierarchiczne oraz metody zaawansowane, takie jak DBSCAN czy Spectral Clustering.

Dla uporządkowania najważniejszych ograniczeń klasteryzacji, poniżej znajduje się zestawienie głównych wyzwań, podzielonych ze względu na źródło problemu:

| Aspekt klasteryzacji | Przykładowe ograniczenie | Wpływ na rezultaty |

|---|---|---|

| Dobór liczby klastrów | Konieczność zadania z góry | Błędny podział, fragmentacja danych |

| Odporność na outlierów | Wysoka podatność algorytmów | Zafałszowane grupowanie |

| Skalowalność | Wysokie wymagania obliczeniowe | Brak możliwości analizy dużych zbiorów |

| Struktura danych | Złożona/nieregularna geometria | Nieadekwatne grupowanie |

| Baza cech | Curse of dimensionality | Spadek jakości klastrów |

| Skala i normalizacja | Różne jednostki miary | Błędne przypisania do grup |

Powyższa tabela pokazuje, że wyzwania w klasteryzacji dotyczą nie tylko algorytmu jako takiego, ale także specyfiki danych i procesu analizy. Najpoważniejsze konsekwencje tych ograniczeń to obniżenie jakości wyników, trudności z interpretacją oraz ograniczenia techniczne przy skalowaniu procesu.

Kiedy warto zastosować klasteryzację danych, a kiedy unikać tej metody?

Klasteryzacja danych jest szczególnie przydatna, gdy pracujemy z danymi nielabelowanymi, a naszym zadaniem jest odkrycie dotąd nieznanych, naturalnych struktur lub segmentów. Świetnie sprawdza się podczas eksploracyjnej analizy dużych zbiorów informacji, gdy nie ustaliliśmy z góry liczby ani rodzaju grup – na przykład w segmentacji klientów, wykrywaniu anomalii, analizie obrazów czy badaniach nad danymi genetycznymi. Algorytmy klasteryzacji, jak DBSCAN, mają zastosowanie także wtedy, gdy analizujemy dane wysokowymiarowe oraz tam, gdzie zależności są nieliniowe, na przykład w detekcji nietypowych zachowań użytkowników.

Klasteryzacja nie jest wskazana, jeśli posiadamy już jasno określone etykiety lub klasy i zależy nam na dokładnej klasyfikacji powiązanej z konkretnymi zmiennymi decyzyjnymi. Stosowanie tej metody jest często nieefektywne przy bardzo wysokim poziomie szumu lub w przypadku braku powiązań pomiędzy zmiennymi — takie warunki mogą prowadzić do tworzenia przypadkowych, nieistotnych grup. Do wyzwań należy również brak jednoznacznych miar oceny jakości podziału na klastry, co utrudnia interpretację wyników, przede wszystkim przy dużej liczbie cech i niewielkiej liczbie obserwacji.

Aby lepiej zobrazować, kiedy warto rozważyć klasteryzację, poniżej przedstawiono typowe kryteria dla różnych sytuacji:

| Przypadek użycia | Wskazane zastosowanie | Unikać stosowania |

|---|---|---|

| Dane nielabelowane | Tak | Nie |

| Wysoce zaszumione dane | Nie | Tak |

| Poszukiwanie nieznanych struktur | Tak | Nie |

| Z góry znane klasy | Nie | Tak |

| Bardzo duża liczba zmiennych, mało przypadków | Nie | Tak |

| Brak powiązań między cechami | Nie | Tak |

| Chęć automatycznej segmentacji | Tak | Nie |

Wnioski z powyższej tabeli sugerują, że klasteryzacja znajdzie zastosowanie przede wszystkim w analizach eksploracyjnych, tam gdzie nie znamy jeszcze istniejących kategorii i interesuje nas poszukiwanie nowych wzorców. Powinniśmy natomiast z niej zrezygnować, gdy dane są bardzo zaszumione, cechy nie mają powiązań lub posiadamy już starannie zdefiniowane klasy. Ostateczny wybór metody zawsze powinien opierać się na charakterystyce zbioru danych oraz celach analizy.