Czym jest regresja liniowa w uczeniu maszynowym?

Regresja liniowa w uczeniu maszynowym to metoda przewidywania wartości liczbowych na podstawie jednej lub wielu zmiennych. Polega na znalezieniu prostej, która najlepiej oddaje zależność między danymi, pozwalając szybko ocenić, jak zmiany jednej cechy wpływają na wynik. To najprostszy i często pierwszy krok do budowania modeli predykcyjnych.

Czym jest regresja liniowa w uczeniu maszynowym i do czego służy?

Regresja liniowa w uczeniu maszynowym to model predykcyjny wykorzystywany do określania zależności między zmienną niezależną (cechą, np. wzrostem, ceną, czasem) a zmienną zależną (wynikiem, np. wagą, sprzedażą, temperaturą) poprzez dopasowanie prostej linii do obserwowanych danych. Celem regresji liniowej jest estymacja wartości wyjściowej (zmiennej zależnej) na podstawie znanych wartości wejściowych (zmiennych niezależnych). Do obliczania parametrów tej linii (nachylenia i wyrazu wolnego) wykorzystuje się najczęściej metodę najmniejszych kwadratów (OLS, ang. Ordinary Least Squares), minimalizując sumę kwadratów różnic między wartościami prognozowanymi a rzeczywistymi.

Model regresji liniowej stosuje się głównie do prognozowania (predykcji) oraz badania siły i kierunku zależności pomiędzy zmiennymi. Najczęściej używa się go w sytuacjach, gdzie występuje liniowy związek pomiędzy zmiennymi, czyli zmiana jednej zmiennej powoduje stałą zmianę drugiej. Przykłady zastosowań obejmują wyceny nieruchomości (prognozowanie ceny na podstawie powierzchni i lokalizacji), szacowanie popytu, przewidywanie wyniku sprzedaży czy modelowanie trendów gospodarczych.

W praktyce regresja liniowa jest narzędziem nie tylko do przewidywania przyszłych wartości, ale również do wyjaśniania i interpretowania wzajemnych relacji między cechami zbioru danych. Dzięki prostocie i szybkości działania sprawdza się w analizie dużych zbiorów informacji, umożliwiając identyfikację najważniejszych czynników wpływających na zjawisko będące przedmiotem analizy. Wynikiem działania regresji liniowej jest równanie prostej regresji, które można wykorzystać do szybkiego wyznaczania prognoz na podstawie nowych danych wejściowych.

Jak działa regresja liniowa krok po kroku?

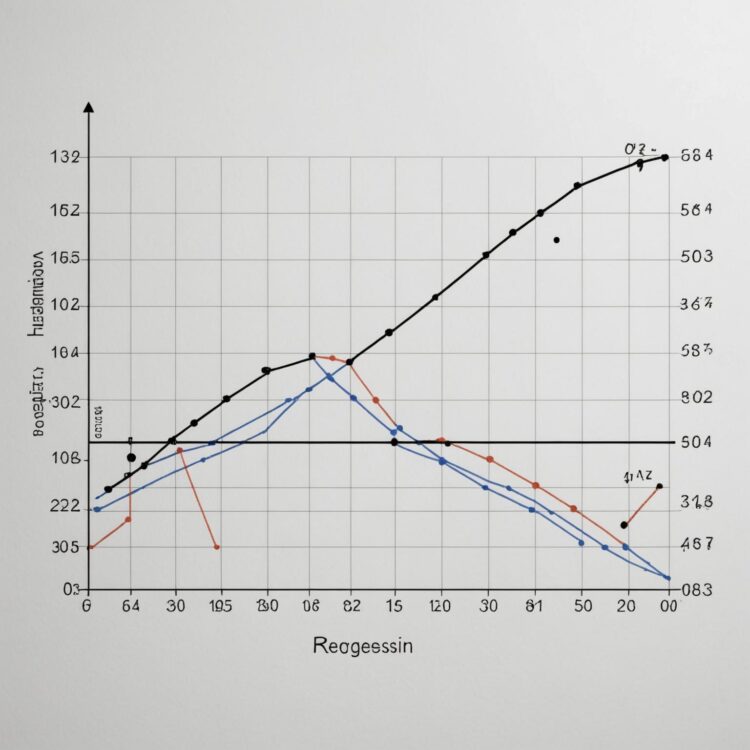

Regresja liniowa polega na dopasowaniu prostej o równaniu y = β₀ + β₁x do zbioru danych tak, by jak najlepiej przewidywała wartość zmiennej zależnej na podstawie zmiennej niezależnej. Proces rozpoczyna się od zebrania danych treningowych, w których każda obserwacja posiada zmienną niezależną x oraz odpowiadającą jej wartość y. Celem jest znalezienie takich wartości parametrów β₀ (wyraz wolny) oraz β₁ (nachylenie), które minimalizują sumę kwadratów różnic między wartościami obserwowanymi, a przewidywanymi przez model.

Najważniejszym etapem jest obliczenie współczynników β₀ i β₁ za pomocą metody najmniejszych kwadratów. Polega ona na rozwiązaniu układu równań normalnych wyprowadzonych z pochodnych funkcji kosztu względem parametrów modelu. Obliczenia można przeprowadzić zarówno ręcznie dla małych zbiorów danych, jak i algorytmicznie – popularne biblioteki Python, takie jak scikit-learn, oferują gotowe implementacje. Należy wykonać standaryzację, jeśli zmienne wejściowe różnią się skalą, by uniknąć zaburzenia procesu estymacji współczynników.

Kolejnym krokiem jest ocena jakości dopasowania modelu. Stosuje się tu m.in. R² (współczynnik determinacji), który informuje, jaki odsetek zmienności zmiennej zależnej tłumaczy model. Sprawdza się również błąd średniokwadratowy RMSE, by ocenić precyzję prognoz. Jeśli wyniki odbiegają od oczekiwań, analizuje się reszty pod kątem rozkładu, wykrywając ewentualne wzorce nieliniowości lub autokorelacji.

Po uzyskaniu satysfakcjonujących rezultatów model można wykorzystywać do prognozowania nowych wartości Y dla nieznanych wartości X. W praktyce regresję liniową najczęściej realizuje się w zautomatyzowanych pipeline’ach uczenia maszynowego – wraz z walidacją krzyżową i testowaniem odporności na nadmierne dopasowanie, co pozwala zwiększyć wiarygodność oraz powtarzalność wyników.

Jakie są podstawowe założenia regresji liniowej?

Regresja liniowa opiera się na kilku kluczowych założeniach, których spełnienie warunkuje poprawność działania modelu, interpretację współczynników oraz wiarygodność predykcji. Jednym z najważniejszych wymagań jest liniowość relacji między zmienną objaśnianą (y) i zmiennymi objaśniającymi (x); oznacza to, że przewidywana wartość y powinna dla każdej jednostkowej zmiany x rosnąć lub maleć o stałą wielkość. Testowanie liniowości często odbywa się poprzez analizę wykresów rozrzutu oraz badanie reszt modelu.

Kolejnym istotnym warunkiem jest niezależność obserwacji, czyli brak autokorelacji. W praktyce oznacza to, że kolejne pomiary nie powinny wpływać na siebie nawzajem, co jest szczególnie istotne w przypadku danych czasowych. Do wykrywania autokorelacji służy test Durbina-Watsona.

Założenie homoscedastyczności wymaga, by wariancja reszt była stała dla wszystkich wartości zmiennych objaśniających. Graficzna metoda oceny tego założenia polega zazwyczaj na analizie wykresu wartości przewidywanych względem reszt – rozrzut powinien być jednorodny bez wyraźnych „lejków” czy wzorców. Niespełnienie tego kryterium może prowadzić do błędnych wniosków statystycznych i nieprawidłowego wyznaczenia przedziałów ufności dla predykcji.

Regresja liniowa zakłada również brak wielokolinearności pomiędzy zmiennymi niezależnymi. Nadmierna współzależność powoduje, że wyznaczenie wartości współczynników staje się niestabilne i podatne na drobne zmiany w danych. Najczęściej analizuje się ten problem, stosując macierze korelacji między zmiennymi lub wskaźnik VIF (Variance Inflation Factor).

Ostatnim kluczowym założeniem jest normalność rozkładu reszt. Pozwala to na prawidłowe szacowanie przedziałów ufności i wartości p. Ocenia się to zarówno wizualnie – poprzez histogram reszt lub wykres Q-Q – jak i za pomocą formalnych testów normalności, takich jak test Shapiro-Wilka.

Jeśli któreś z założeń nie jest spełnione, model regresji liniowej staje się podatny na błędne predykcje, niestabilność współczynników i trudności interpretacyjne. Konieczna jest wtedy modyfikacja modelu lub transformacja danych, aby zapewnić zgodność z teoretycznymi wymaganiami.

Kiedy warto wybrać regresję liniową zamiast innych modeli?

Regresję liniową warto wybrać przede wszystkim, gdy zależność między zmiennymi niezależnymi a zmienną zależną jest zbliżona do liniowej i potwierdza to analiza wykresów rozrzutu lub testy dopasowania. Model ten cechuje się dużą efektywnością obliczeniową i niską złożonością, co jest istotne przy dużych zbiorach danych oraz gdy dostępny jest ograniczony budżet obliczeniowy lub czasowy.

Bardzo dobre rezultaty regresja liniowa daje, gdy liczba cech (zmiennych) jest niewielka, a dane nie zawierają silnych korelacji wielokrotnych (brak wielokolinearności) i odstających obserwacji. Model ten jest również preferowany, gdy zależy nam na łatwej interpretacji parametrów – na przykład w zastosowaniach biznesowych lub naukowych, gdzie wyjaśnienie wpływu poszczególnych cech na wynik ma znaczenie.

Regresja liniowa sprawdzi się także w sytuacjach, gdy potrzebny jest szybki model bazowy, który pozwoli ocenić prostotę i skuteczność na tle bardziej złożonych metod. W takich przypadkach stanowi dobry punkt odniesienia (baseline), umożliwiający późniejszą ocenę wartości dodanej zaawansowanych technik.

Poniżej przedstawiono porównanie sytuacji, w których regresja liniowa jest lepszym wyborem niż modele nieliniowe, drzewa decyzyjne czy sieci neuronowe:

| Typ problemu | Regresja liniowa | Modele złożone (np. drzewa, sieci) |

|---|---|---|

| Zależność liniowa | Bardzo dobra skuteczność przy prostocie | Brak przewagi, nadmiarowa złożoność |

| Interpretowalność | Łatwo zidentyfikować wpływ zmiennych | Mało przejrzyste wyniki |

| Szybkość treningu | Bardzo szybki trening nawet na dużych zbiorach | Może być czasochłonny |

| Przeciwdziałanie overfittingowi | Niska podatność w prostych przypadkach | Wyższe ryzyko przy złożonych modelach |

| Liczba obserwacji względem cech | Lepiej radzi sobie przy małej liczbie cech i wystarczająco wielu próbkach | Skuteczniejsze, gdy cech jest dużo |

Na podstawie porównania widzimy, że regresja liniowa będzie najczęściej korzystna, gdy szczególnie ważne są interpretowalność, prostota oraz szybkość działania. W sytuacji, gdy dane spełniają założenia modelu liniowego, wdrażanie bardziej zaawansowanych rozwiązań może nie tylko nie przynieść dodatkowych korzyści, ale także zwiększyć ryzyko overfittingu lub utrudnić interpretację wyników.

Jak interpretować wyniki regresji liniowej w praktyce?

Interpretacja wyników regresji liniowej w praktyce opiera się na analizie kilku kluczowych parametrów modelu. Najważniejsze z nich to współczynniki regresji (parametry beta), które wskazują, o ile zmieni się wartość zmiennej zależnej przy jednostkowej zmianie danej zmiennej niezależnej, przy pozostałych zmiennych stałych. Na przykład, jeśli współczynnik wynosi 2, każda jednostka wzrostu danej cechy zwiększa prognozowaną wartość wyniku o 2 jednostki.

Istotność statystyczna współczynników oceniana jest przy pomocy wartości p-value. Wynik p < 0,05 oznacza, że istnieje mniej niż 5% prawdopodobieństwo, iż zaobserwowany efekt jest dziełem przypadku, co przemawia za statystyczną istotnością wpływu danej zmiennej. Równocześnie warto zwrócić uwagę na przedziały ufności dla współczynników – wąski przedział ufności świadczy o większej precyzji oszacowania.

Skuteczność modelu mierzy się współczynnikiem determinacji R², który informuje, jaki procent zmienności zmiennej zależnej wyjaśniają wszystkie zmienne niezależne łącznie. R² bliskie 1 potwierdza bardzo dobrą zgodność modelu z danymi, natomiast niskie R² wskazuje na niewielką siłę wyjaśniającą modelu. W praktyce porównuje się także skorygowany R² (adjusted R²), który uwzględnia liczbę predyktorów i zapobiega „przeuczeniu” modelu.

Do praktycznej weryfikacji jakości i trafności modelu regresji liniowej konieczna jest również ocena reszt – różnic pomiędzy wartościami rzeczywistymi a prognozowanymi. Reszty powinny być losowo rozproszone, o średniej zbliżonej do zera oraz nie wykazywać trendów. Systematyczne wzory, nieliniowość, czy zależności w rozkładzie reszt mogą wskazywać na niespełnienie założeń modelu lub konieczność uwzględnienia kolejnych zmiennych.

Poniższa tabela przedstawia zestawienie interpretacji kluczowych parametrów regresji liniowej z przykładami wartości:

| Parametr | Opis | Przykład interpretacji |

|---|---|---|

| Współczynnik regresji (beta) | Siła i kierunek wpływu zmiennej niezależnej | beta = 3: każdy dodatkowy rok edukacji zwiększa dochód o 3 tys. |

| p-value | Prawdopodobieństwo uzyskania wyniku przez przypadek | p = 0,001: efekt istotny statystycznie |

| R² | Procent wyjaśnionej zmienności | R² = 0,85: 85% zmienności wyjaśnia model |

| Reszty | Różnice między wartościami rzeczywistymi i przewidywanymi | Średnia reszt = 0, brak wzoru → model poprawny |

Tabela ułatwia szybkie skojarzenie wartości poszczególnych parametrów z ich praktycznym znaczeniem podczas oceny i interpretacji modelu regresji liniowej. Sprawna interpretacja tych wyników pozwala na trafne wnioskowanie, jednak ważne jest uwzględnienie zarówno istotności statystycznej, jak i jakości dopasowania oraz rozkładu reszt.