Jak działają sieci konwolucyjne i co mają wspólnego z macierzami?

Sieci konwolucyjne rozpoznają wzorce na obrazach, przetwarzając je za pomocą operacji matematycznych na macierzach. Sercem ich działania są filtry przesuwane po obrazie — to właśnie wielokrotne mnożenie macierzy pozwala im wyłapywać kształty, kolory czy nawet bardziej złożone struktury. Dzięki temu mogą efektywnie analizować dane wizualne, opierając się wyłącznie na matematyce operacji macierzowych.

Czym są sieci konwolucyjne i do czego się je wykorzystuje?

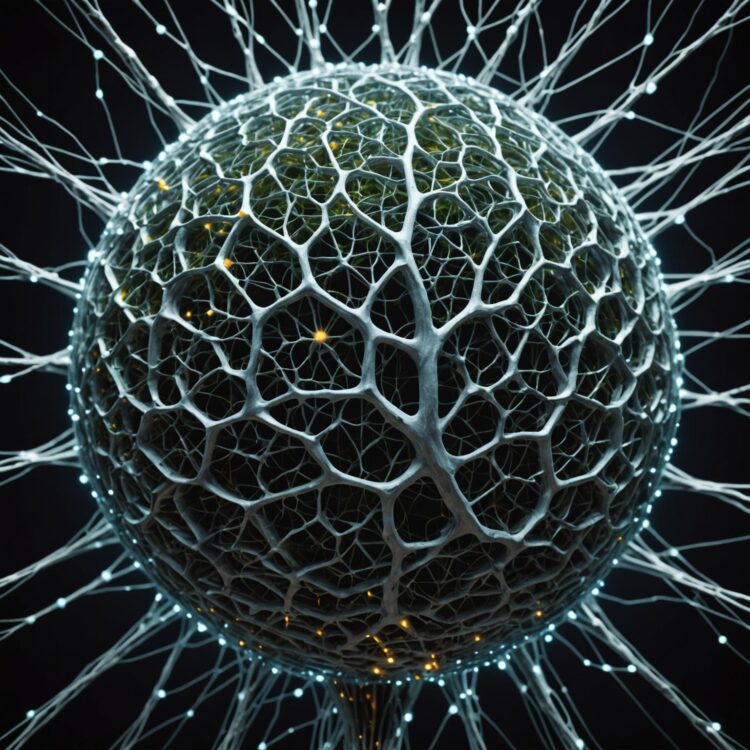

Sieci konwolucyjne (CNN, convolutional neural networks) to rodzaj sztucznych sieci neuronowych, które przetwarzają dane o strukturze przestrzennej, takie jak obrazy lub sekwencje danych. Zbudowane są z warstw, w których podstawową operacją jest konwolucja, dzięki czemu sieci te potrafią automatycznie wykrywać ważne cechy w danych wejściowych bez ręcznego projektowania filtrów. W odróżnieniu od standardowych sieci neuronowych, w CNN jedna warstwa przetwarza fragmenty obrazu (tzw. receptywne pola), a nie wszystkie jego piksele naraz, co znacznie zmniejsza liczbę parametrów i poprawia efektywność uczenia.

Sieci konwolucyjne są stosowane głównie w przetwarzaniu obrazów, ale ich możliwości rozciągają się także na analizę dźwięku i tekstu. Najczęstsze wykorzystanie obejmuje rozpoznawanie obrazów, klasyfikację obiektów, detekcję i lokalizację obiektów na zdjęciach oraz segmentację obrazów. Przy zadaniach takich jak rozpoznawanie twarzy, identyfikacja znaków drogowych czy analiza medycznych zdjęć rentgenowskich, CNN regularnie osiągają lepsze wyniki niż tradycyjne metody. W ostatnim czasie znalazły zastosowanie również w analizie danych biologicznych, przetwarzaniu mowy i tłumaczeniu tekstów.

W praktyce CNN stały się podstawą w systemach bezpieczeństwa, samochodach autonomicznych oraz nowoczesnej diagnostyce medycznej. Przemysł wykorzystuje je do kontroli jakości obrazu i systemów wizyjnych do inspekcji, a aplikacje mobilne mogą z ich pomocą rozpoznawać sceny lub działać w środowiskach rozszerzonej rzeczywistości. Ciekawe przykłady to także generowanie nowych obrazów (np. deepfake) lub identyfikacja stylów w dziełach artystycznych.

Na poniższej tabeli zestawiono główne obszary zastosowań sieci konwolucyjnych wraz z przykładami zadań i typowych zbiorów danych:

| Obszar zastosowań | Typowe zadania | Przykładowe zbiory danych |

|---|---|---|

| Rozpoznawanie obrazów | Klasyfikacja obiektów, identyfikacja twarzy | ImageNet, CIFAR-10, LFW |

| Analiza medyczna | Segmentacja zdjęć, wykrywanie guzów | LUNA16, ISIC, CheXpert |

| Analiza tekstu | Ekstrakcja cech, klasyfikacja sentymentu | IMDB, AG News |

| Przetwarzanie mowy | Rozpoznawanie słów, identyfikacja mówców | LibriSpeech, TIMIT |

| Systemy wizyjne | Autonomiczne pojazdy, monitoring bezpieczeństwa | Cityscapes, KITTI |

Zastosowania CNN obejmują zarówno standardowe zadania komputerowego rozpoznawania obrazów, jak i zaawansowaną analizę danych medycznych, językowych oraz dźwiękowych. Wszechstronność tych sieci wynika z ich umiejętności uczenia się cech na podstawie surowych danych, co odróżnia je od klasycznych rozwiązań opartych na ręcznym projektowaniu filtrów.

Jak działa warstwa konwolucyjna w sieci neuronowej?

Warstwa konwolucyjna w sieci neuronowej działa poprzez przetwarzanie danych wejściowych (np. obrazu) za pomocą filtrów, czyli niewielkich macierzy wag. Filtry te przesuwają się (wykonują konwolucję) po całym obrazie, wykonując jednocześnie mnożenie i sumowanie wartości pikseli z odpowiadającymi im wagami filtru. W efekcie tej operacji powstają mapy cech – nowe reprezentacje danych, które podkreślają istotne wzorce, na przykład krawędzie, tekstury czy inne lokalne cechy.

Kluczową zaletą warstwy konwolucyjnej jest współdzielenie wag: ten sam zestaw wag stosowany jest do wielu fragmentów obrazu. Dzięki temu można wykrywać te same cechy niezależnie od położenia, a liczba parametrów wymagających uczenia jest znacząco mniejsza niż w klasycznych, gęsto połączonych warstwach. Filtry mają różne rozmiary – najczęściej spotyka się macierze 3×3, 5×5 lub 7×7 – a ich liczba jest określana na etapie projektowania sieci. Pozwala to warstwie konwolucyjnej uczyć się wielu różnych cech równocześnie.

W praktyce, warstwa konwolucyjna realizuje kilka kroków procesu przetwarzania danych, które można wyróżnić:

- Przesuwanie filtru po obrazie fragment po fragmencie (z określonym krokiem, tzw. „stride”).

- Przemnażanie wartości pikseli pod filtrem przez odpowiednie wagi filtru i sumowanie tych wyników.

- Tworzenie nowej macierzy (mapy cech), w której każda wartość odpowiada jednemu położeniu filtru na obrazie.

- Opcjonalna normalizacja i zastosowanie funkcji aktywacji (np. ReLU).

Te kroki są realizowane osobno dla każdego filtru, a uzyskane mapy cech są łączone (stackowane), tworząc wielowymiarową reprezentację danych przekazywaną do kolejnych warstw sieci.

Stosowanie warstw konwolucyjnych pozwala na wykrywanie coraz bardziej złożonych wzorców dzięki nakładaniu kolejnych warstw, które przetwarzają coraz bardziej abstrakcyjne cechy. W pierwszych warstwach wykrywane są proste struktury, takie jak linie czy krawędzie, natomiast kolejne odpowiadają za rozpoznawanie bardziej złożonych elementów. Skuteczność warstw konwolucyjnych potwierdzają liczne badania na dużych zbiorach danych, w tym ImageNet, gdzie sieci konwolucyjne osiągają najlepsze wyniki w zadaniach klasyfikacji i detekcji obiektów.

Co mają wspólnego operacje konwolucyjne z działaniami na macierzach?

Operacje konwolucyjne w sieciach neuronowych są realizowane jako specjalny rodzaj przemnożenia macierzy, gdzie filtr (czyli niewielka, często 3×3 lub 5×5 macierz wag) przemieszcza się po danych wejściowych w postaci macierzy (np. obrazu). Sama konwolucja polega na wykonywaniu iloczynu (ang. dot product) odpowiadających sobie elementów wycinka macierzy wejściowej oraz filtra, a następnie zsumowaniu ich wyników dla każdego położenia filtra na obrazie. Proces ten można formalnie opisać jako przesuwanie okna macierzy wag nad większą macierzą i iteracyjne liczenie sum iloczynów elementów.

Operacje konwolucyjne wymagają efektywnego podejścia do mnożenia i sumowania elementów macierzy oraz sprawnej organizacji przesuwania okna – tzw. „sliding window”. Często do realizacji konwolucji wykorzystuje się techniki typu „im2col”, gdzie fragmenty macierzy wejściowej są przekształcane do nowych struktur, by umożliwić ich szybkie przemnożenie za pomocą wysoko zoptymalizowanych algorytmów macierzowych (np. BLAS, GEMM). Dzięki temu, mimo że konwolucja i standardowe mnożenie macierzy mają różną interpretację matematyczną, konwolucje mogą być faktycznie realizowane przez odpowiednio przygotowane operacje na macierzach.

Relacja pomiędzy konwolucją a działaniami na macierzach najlepiej obrazuje poniższa tabela, porównująca kluczowe aspekty tych operacji:

| Cecha | Standardowe mnożenie macierzy | Konwolucja |

|---|---|---|

| Rozmiar macierzy wejściowych | Obie macierze dowolnych, zgodnych wymiarów | Duża macierz (np. obraz) i mały filtr (np. 3×3) |

| Sposób przemieszczania | Brak przesuwania; całość mnożona jednorazowo | Filtr przesuwa się po macierzy wejściowej |

| Łączna liczba operacji | wielkość_A wielkość_B | wielkość_filtra liczba pozycji przesunięcia |

| Optymalizacja sprzętowa | Zoptymalizowane biblioteki (np. BLAS) | Często przekształcana do mnożenia macierzy |

| Zależność od lokalnego kontekstu | Nie | Tak (operuje na lokalnych fragmentach macierzy wejściowej) |

Zestawienie pokazuje, że chociaż matematyczna natura obu operacji jest różna, sposoby ich realizacji w praktyce opierają się na wspólnych operacjach macierzowych. Współczesne biblioteki deep learning do realizacji konwolucji często korzystają z przekształcania jej do postaci mnożenia dużych macierzy, by uzyskać maksymalną wydajność na GPU i CPU, co stanowi kluczowy element ich praktycznego pokrewieństwa.

W jaki sposób sieci konwolucyjne rozpoznają wzorce na obrazach?

Sieci konwolucyjne rozpoznają wzorce na obrazach poprzez stopniowe wydobywanie coraz bardziej złożonych cech przy użyciu filtrów konwolucyjnych. Na początkowych warstwach detekcja obejmuje podstawowe struktury, takie jak krawędzie czy rogi, ponieważ filtry wykrywają różnice jasności i proste kształty na małych fragmentach obrazu. Z każdą kolejną warstwą wykrywane są coraz bardziej złożone kombinacje tych prostych cech – na przykład tekstury, fragmenty obiektów, aż po całe obiekty na późniejszych warstwach.

Proces rozpoznawania polega więc na nakładaniu filtrów w postaci niewielkich macierzy na cały obraz (lub na „mapy cech” wygenerowane przez wcześniejsze warstwy) i obliczaniu odpowiedzi – zazwyczaj za pomocą przemnożenia wartości piksela przez wartości filtra i sumowania tego wyniku. Efektem są tzw. mapy aktywacji, które wskazują na obecność konkretnego wzorca w danym fragmencie obrazu. Jednocześnie sieć uczy się, które filtry są najbardziej istotne dla danego zadania, optymalizując ich wartości podczas procesu uczenia.

W praktyce rozpoznawanie wzorców przez sieci konwolucyjne przebiega etapowo i hierarchicznie. Przykładowo, w klasycznych architekturach, takich jak AlexNet czy VGG, pierwsze warstwy wykrywają cechy o wielkości 3×3 lub 5×5 pikseli, natomiast głębsze warstwy gromadzą informacje z dziesiątek, a nawet setek pikseli, łącząc proste cechy w skomplikowane struktury. Dzięki temu sieć potrafi rozpoznać obiekt niezależnie od jego położenia, skalowania czy lekkich zniekształceń, ponieważ cechy na różnych poziomach są reprezentowane w sposób przestrzennie niejawny.

Zaawansowane architektury, takie jak ResNet, wykorzystują dodatkowe połączenia skip connections między warstwami, co pozwala na wydajniejszą detekcję i propagację kluczowych wzorców nawet w bardzo głębokich sieciach. W sieciach tych następuje nie tylko wykrywanie wzorców, ale również ich odpowiednie „ważenie” i przekierowanie przez całą architekturę, co prowadzi do precyzyjnego rozpoznania nawet przy dużej złożoności danych wizualnych. Dodatkowo, mechanizmy takie jak normalizacja grupowa (batch normalization) poprawiają stabilność rozpoznawania wzorców na różnych etapach uczenia i testowania.

Dlaczego macierze są kluczowe w przetwarzaniu danych przez sieci konwolucyjne?

Sieci konwolucyjne operują na danych w formie macierzy, ponieważ obrazy czy sygnały to zbiory wartości liczbowych uporządkowanych w dwuwymiarowych lub wielowymiarowych układach. Macierze umożliwiają przedstawienie każdego piksela obrazu jako elementu konkretnego wiersza i kolumny. Dzięki temu sieć neuronowa może precyzyjnie obliczać zależności przestrzenne i powiązania między poszczególnymi fragmentami danych wejściowych.

Operacje konwolucyjne, które stanowią podstawę działania warstw konwolucyjnych, polegają na wykonywaniu działań między dwoma macierzami: macierzą wejściową (np. obrazem) oraz macierzą filtrów (ang. kernel). Wynikowa macierz, zwana mapą cech, jest efektem przesuwania filtra po obrazie i wykonywania lokalnych iloczynów skalarnych. Taki sposób przetwarzania pozwala na wykrywanie złożonych wzorców, krawędzi lub tekstur w danych bez konieczności ręcznego definiowania cech.

Konieczność reprezentowania danych i operacji w postaci macierzy wynika także z wydajności obliczeniowej. Nowoczesne procesory graficzne (GPU) są projektowane do szybkiego wykonywania równoległych operacji macierzowych. W praktyce pozwala to na trenowanie głębokich sieci konwolucyjnych na bardzo dużych zbiorach obrazów, ponieważ każda operacja konwolucji, normalizacji czy propagacji wstecznej może być sprowadzona do działań na macierzach.

W kontekście sieci konwolucyjnych macierze są niezbędne nie tylko do reprezentowania obrazów i filtrów, ale także do przechowywania wag w głębokich warstwach, wyników pośrednich i gradientów podczas procesu uczenia. Przykładowo, przekształcenia liniowe, takie jak warstwy gęste (fully connected), czerpią bezpośrednio z algebry macierzy, a korzystanie z optymalizowanych bibliotek liniowej algebry, takich jak BLAS czy cuDNN, bezpośrednio wpływa na efektywność trenowania sieci.

Macierze umożliwiają także łatwą ekspansję do wyższych wymiarów, co odgrywa istotną rolę przy analizie danych wielokanałowych, jak obrazy RGB czy sekwencje wideo. Dzięki tej uniwersalności macierze stanowią podstawę zarówno dla teoretycznych modeli sieci konwolucyjnych, jak i dla praktycznych implementacji w popularnych frameworkach, takich jak TensorFlow czy PyTorch.